参照图一数据中心能耗模型中的分层,继续对每一层能耗使用和节能情况进行详细分析,基础设施建设和维护阶段节能不在此讨论范围。

图一:数据中心能耗模型

1、建筑层

数据中心和传统建筑不同,存在大型暖通系统,但是现阶段设计单位针对性的优化并不多,特别是在气流组织等细节方面缺乏细化设计。

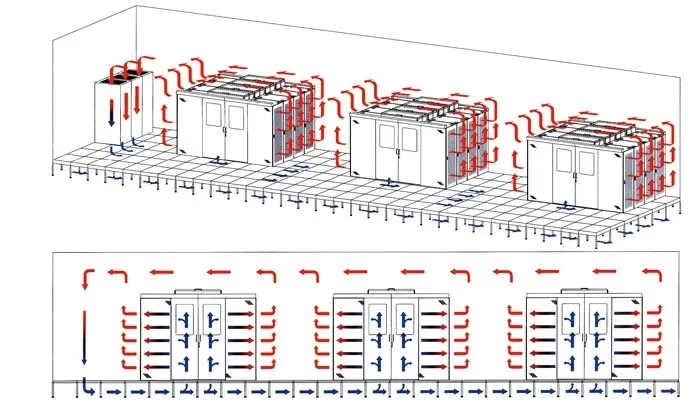

图二:机房气流组织模型

以图二机房气流组织模型为例,一般冷空气从末端空调出风后,均需经过向下、向前、横向、向上、向后、再向下等一系列的方向变化才回到末端空调进风口,形成气流循环。可以看到现有气流组织涉及大量的方向调整,每次方向调整都需要消耗一定能量。因此可以考虑把空调的送风和回风系统分开,并把风向和IT设备的风向调整成一致,减少气流方向变化造成的能耗损失。

同时,送风口和回风口附近,包括桥架、横梁、照明灯具等位置都会对气流产生很大影响,因此一定要结合BIM等模型,多个设计专业做好联动,对机房内送风、回风等整个通道进行深化设计,避免只是实现功能的堆叠,减少由气流碰撞而造成的能耗损失。

2、IDC层

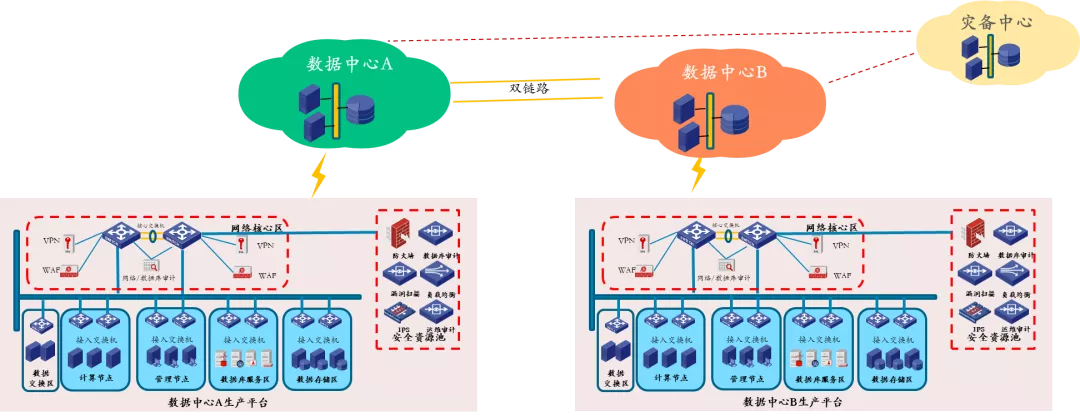

从安全性考虑,金融等很多客户都在部署两地三中心、双活等架构,如图三所示,这种架构确实能保证业务连续性。

图三:标准两地三中心业务架构

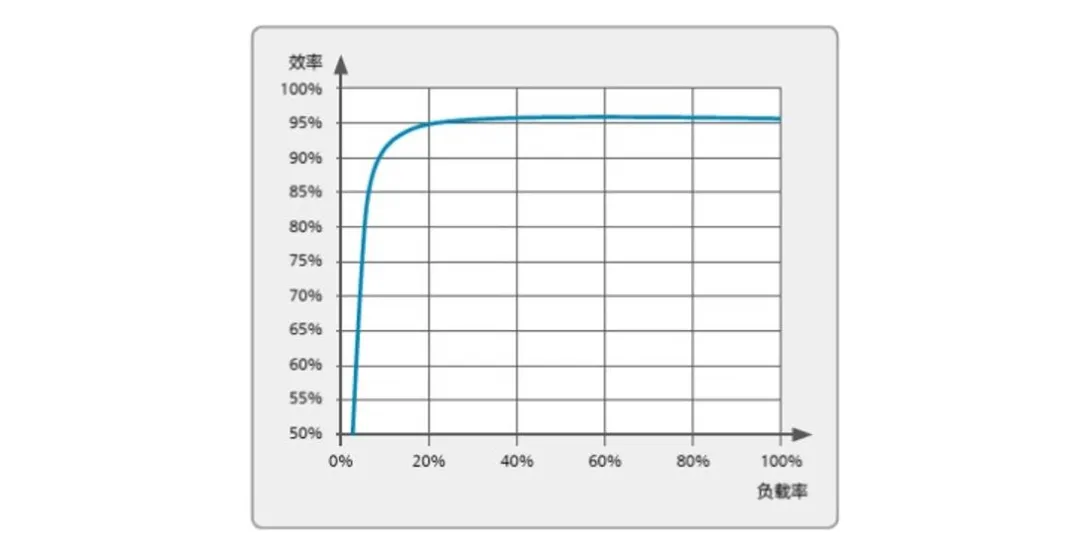

但在能耗方面,一般此种架构均需搭建两套或两套以上的IT系统,需要搭配4套以上UPS系统。一般主数据中心分担业务60%-70%,备数据中心分担30%-40%,灾备中心闲置会更严重,平均每套UPS系统负载率不会超过25%,大部分情况下甚至低于20%,如图四负载率和转化率关系图可知,UPS将达不到最佳的工作效率,常规估算4套UPS浪费能耗综合将超过UPS总能耗5%。所以需要在业务连续性和节能之间找到平衡。数据中心也可以进行针对性的调整优化,比如可以由数据中心整体承接整个业务系统的SLA,而不是由每个数据中心单独承接各自的SLA。或者在搭建业务架构时,结合数据中心现状进行更多的优化。

图四:某模块化UPS负载率和转化效率关系图

3、IAAS层

前面已经提到,IT设备自身的节能空间比较大。来看今年2月一则浪潮服务器在测评中获奖的新闻,主要内容是在同等硬件配置情况下,浪潮工程师对服务器组件和热管理系统设计进行全方面优化,实现服务器节能50%左右,实现能源利用最大化。文章中200多字4次提到了风扇,所以IT设备通过优化内部气流组织和改善温场分布实现节能,空间很大, IT硬件厂商在设计数据中心专用机架时,应该联合更多的暖通行业专家进行深度的优化,同时做好和机房气流组织的联动。

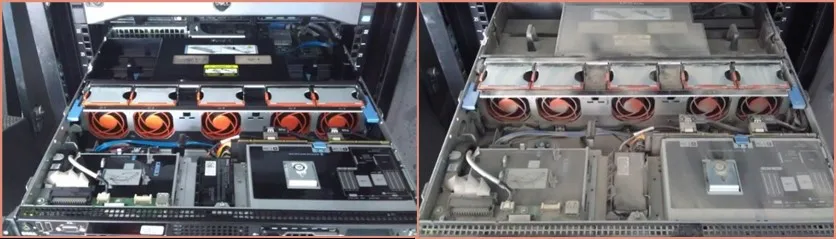

图五:IT设备清洁前后对比

数据中心运维人员都会按周期对基础设施进行各项维护保养,但是客户或客户代维对IT设备的维护保养,一般仅限于硬件上下架和网络割接等,几乎不对IT设备进行清洁。如图五所示,数据表明,定期对IT设备特别是风扇进行清洁除尘、润滑,可有效的提升风扇效率。按照常规估算,可以降低风扇能耗5%, IT能耗1%,将会节约数据中心整体能耗0.7%。但一般客户是按功率密度租用机柜,只会考虑整体功率会不会超标,节能的意愿并不强烈。数据中心可以推出相应的政策,引导客户做这方面节能,在IT维护成本和节能方面找到平衡。

4、PAAS层

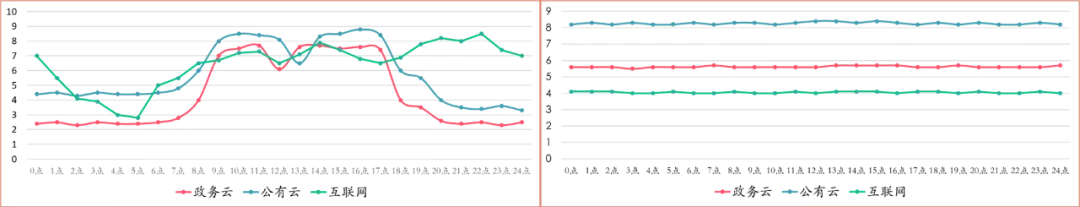

来看一组对比,图六左图是理想中一天以小时为单位,政务云、公有云和互联网客户的业务曲线,也可等效为能耗曲线,可以看到业务和时间关联性很大。但是结合几个数据中心进行实际测试后发现,如图六右图所示,无论政务云、公有云还是互联网客户,全天每小时的能耗并没有太大变化,甚至工作日和周末也没有变化。通过调查发现有几个原因1)任务机制更多关注负载均衡、响应时间等性能指标,忽视能耗控制。2)数据机制更多关注访问效率、一致性,忽视对数据多重冗余等的能耗控制。3)集成商和应用商更关注QOS和SLA,缺少主动的节能意愿。所以数据中心服务商应该结合基础设施、IT硬件和软件行业,出台针对性的优惠策略,在稳定和节能间找到平衡。

图六:标准的业务系统和实际业务系统24小时能耗曲线

5、SAAS层

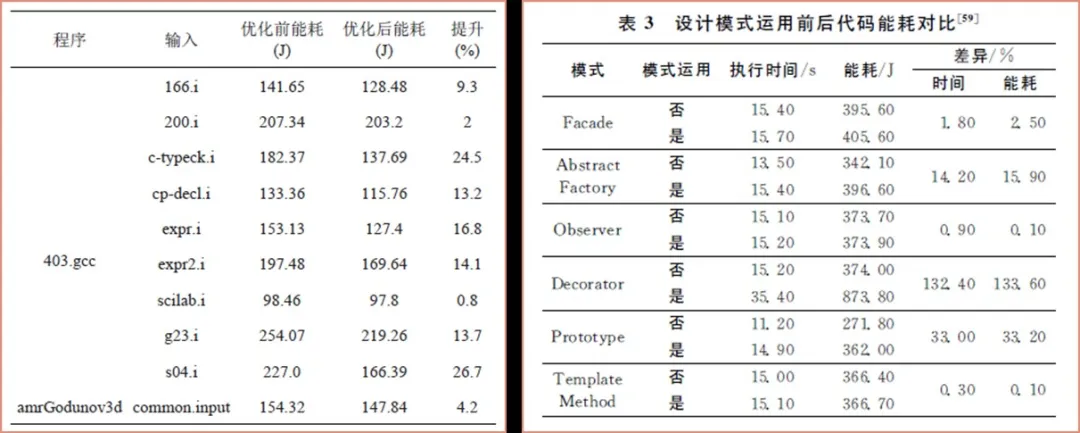

程序代码节能是最容易被忽视的部分,因为程序编写更多是以结果为导向,只要实现功能即可,很少有人关注程序能耗,研究表明:

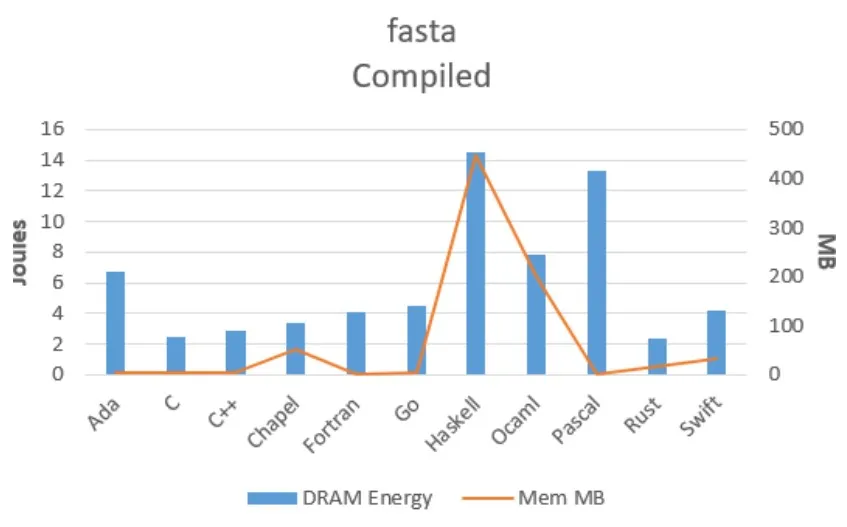

1)不同程序语言,能耗差别较大,以图七为例,按照相同逻辑实现某一功能,不同语言之间能耗差别达4倍以上。

图七:Energy Efficiency Across Programming Languages

2)相同程序语言,不同人编写,能耗差别也较大。通过图八可以看出,同样程序语言,不同的实现逻辑,最多能耗相差20%以上。虽说条条道路通罗马,但是不同道路通罗马的人力、财力、时间等成本都是不同的,数据中心行业应该协同相关行业建立数据中心绿色代码评价机制,在代码可用和节能间找到平衡。

6、数据层

公开数据表明,2020年全球产生数据达到44ZB,这些数据根据使用频次不同又分为热数据、温数据、冷数据、冰冻数据等多个分级,而其中冰冻数据使用频次基本小于每年2次。根据易华录集团给出的数据,如果对使用频次低或者使用实时性要求不高的数据,利用光存储去替代电存储或磁存储,将节约90%的能耗。在一般业务架构中,按PUE=1.3、存储能耗占IT系统35%、冷数据占数据总量40%测算,冷数据能耗已占到数据中心总能耗的10%,虽然不是所有数据都能利用光存储替换,但应该在业务架构上更多的结合数据中心实际情况进行优化,在实时性和节能间找到平衡。

7、辅助支撑层

安防、照明、弱电等系统均属于辅助支撑。以安防为例,按照最新规范,园区安防一般分5级,每级重点不同,对系统要求不同,码流和分辨率等参数也应该不同。

1)对园区公区、楼宇围墙,重点关注的是对入侵的检测和预警,需要安保人员线下配合。

2)对楼内公区,重点关注未经授权的跨区活动,需要人脸识别、动态侦测等技术。

3)对机房公区、冷通道区,重点记录什么人在什么时间对什么系统进行了操作,也便于后期追责。

所以对不同区域应采用不同的技术、设置不同的码流、设置不同的分辨率,而不是采用统一的标准。按常规估算,如对园区围栏优化分辨率、对楼内公区采用动态侦测等技术,降低存储和网络设备能耗可以达到10%以上。所以有必要考虑对辅助支撑层的各项应用根据功能环境的不同进行细化,而不是采用统一的高标准。

8、运维管理层

现阶段,很多厂家都已提出并实现AI+BA等智能化节能方案,确实实现了能耗的精准控制,但是还可以做的更精细。以图九为例分析暖通系统现状。

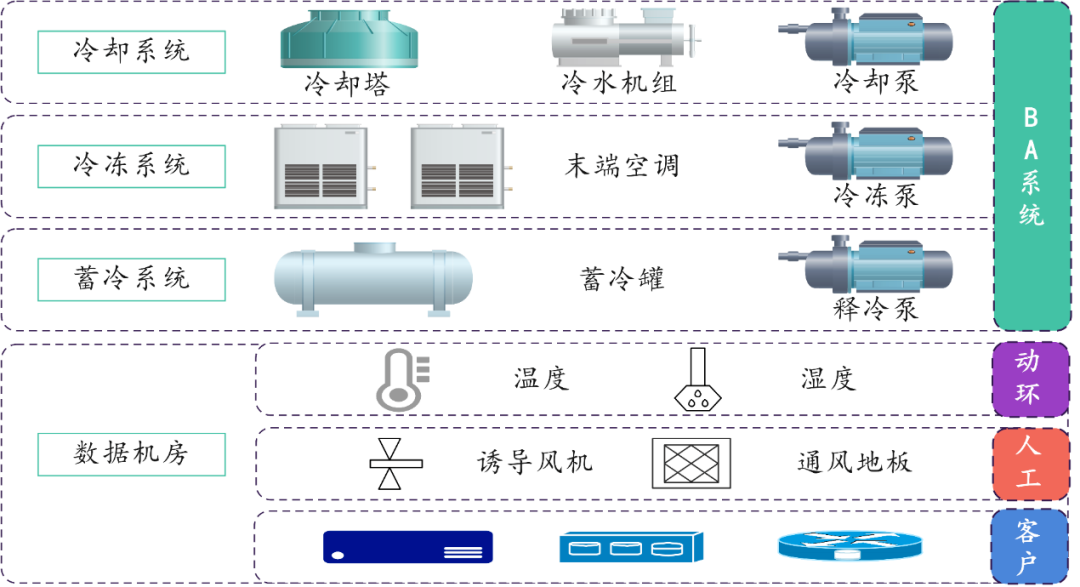

图九:数据中心暖通系统逻辑图

冷却、冷冻、蓄冷释冷和末端系统,一般由BA进行控制。数据机房内可分三部分,温湿度由动环系统采集(BA也可采集),机房内诱导风机、通风地板一般不在自控范围内,都是人工控制,客户的IT设备比如风扇等,未纳入到数据中心运维的监控体系,所以从逻辑上整个暖通系统分为能自控、可手动控制和不能控制三部分。就像手动挡车比自动挡车省油一样,不是自动挡不好,而是自动挡不能像驾驶员一样,采集所有信息进行综合分析。对于AI+BA也一样,数据中心行业应该纳入更多检测或监控节点,并联合IT设备厂家开放IT设备风扇等接口,纳入统一监控体系,通过全系统联动达到最优节能。

9、间接节能输出

数据中心要建立类似海绵城市的概念,和自然充分融合,利用好IT设备的热能、蒸发冷却废水,实现二次利用。

最后做一下总结,数据中心前期的节能更多是围绕基础设施建设和运维开展,而对占比达到80%的基础设施之外能耗关注的过少,而且由于前面介绍的原因,IT硬件、软件开发、IT维护等行业自身节能的意愿并不强烈,同时数据中心服务商也没有制定相关鼓励策略推动这些方面节能。因此,如图十所示,需要构建以数据中心为中心,由数据中心行业组织牵头,协同IT硬件、应用软件等上下游行业,建立数据中心绿色节能的生态圈,实现多方共赢。

图十:数据中心绿色节能生态圈

针对数据中心在政策上和绿色节能评价上,完善行业标准。协同IT硬件、软件、设计和集成等行业,在IT能效、业务架构上、代码效率上,针对数据中心做出绿色等级划分。数据中心运营者应积极推动落实这些政策标准,对符合客户给予优惠的销售策略,实现数据中心上下游相关行业的共赢,共同构建数据中心绿色节能生态圈,降低数据中心整体能耗,提升整个数据中心的效率,减少碳排放,站在全社会的角度做出数据中心行业的贡献。(作者:联通数字科技有限公司 车凯)

来源:“数据中心节能技术委员会”微信公众号(授权转载)注明:转载文章仅用于分享,不用于任何商业用途。如涉及版权问题,敬请后台联络授权或议定合作,我们会按照版权法规定第一时间为您妥善处理。